Det finns idag många olika AI-tjänster som skapar bilder på sådant som egentligen inte finns. Ett bra exempel är https://thispersondoesnotexist.com som automatiskt genererar porträtt på personer som inte existerar, såsom den här:

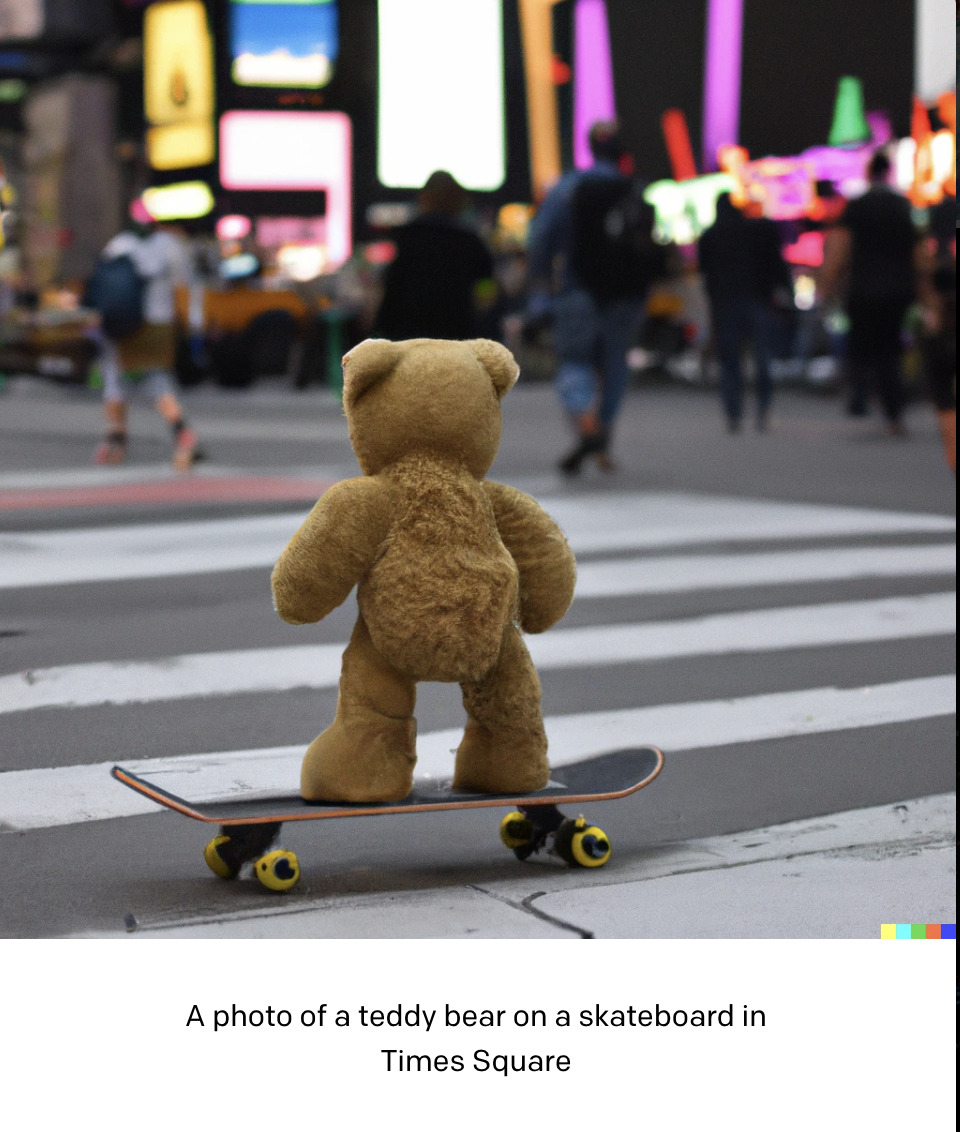

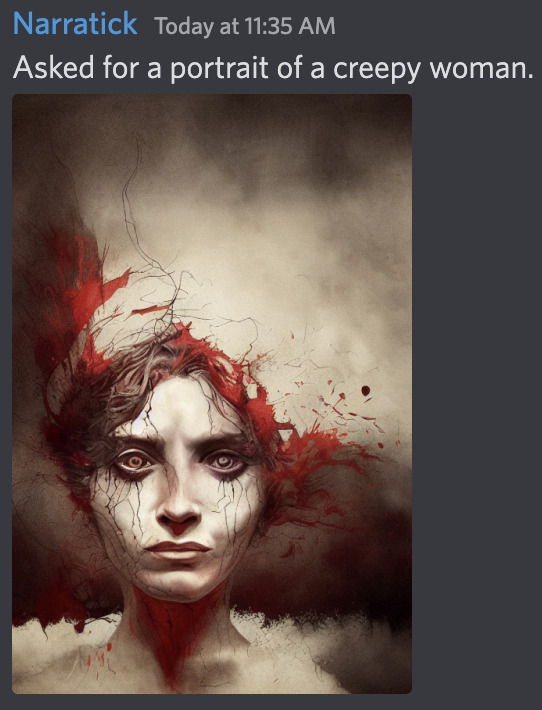

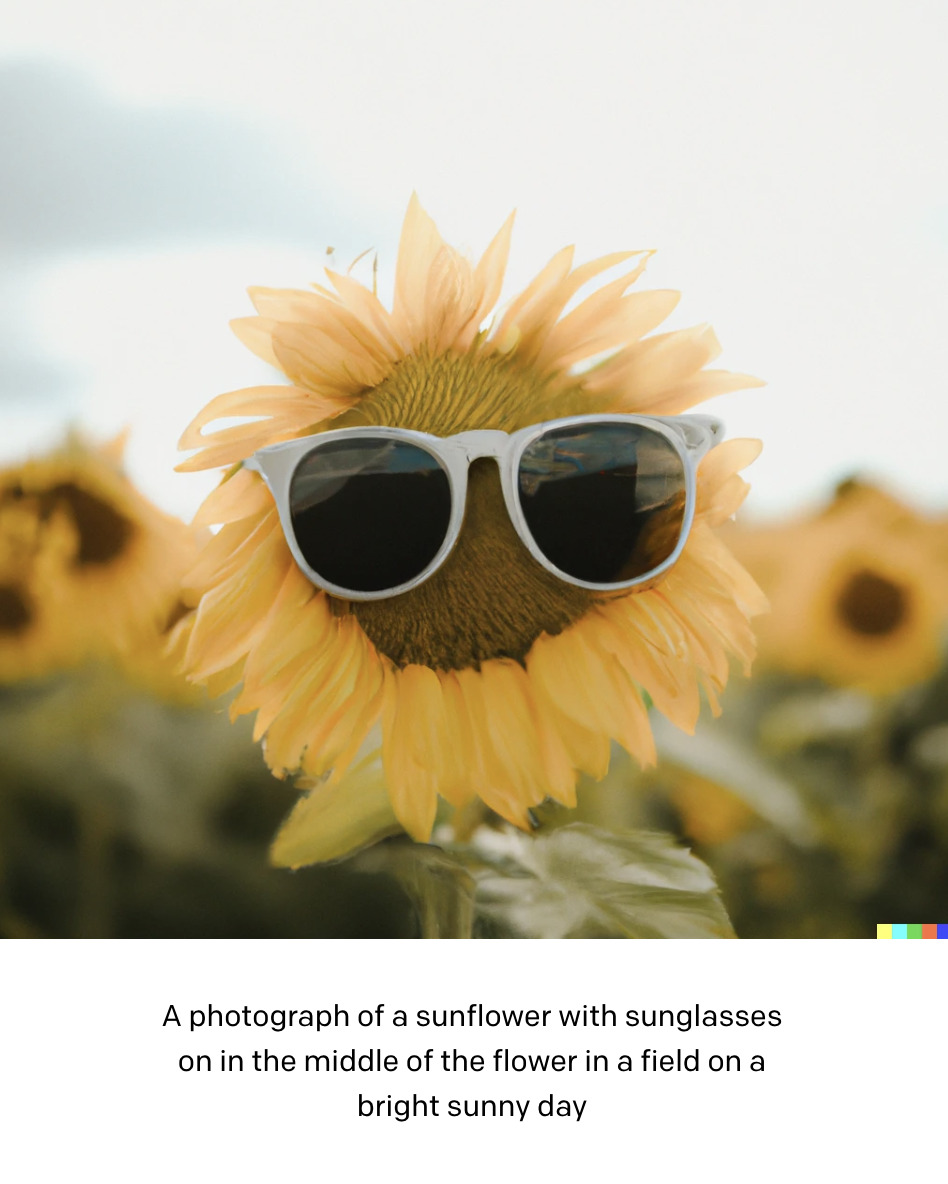

Ett annat exempel är tjänster som DALL-E och Midjourney, som skapar illustrationer/foton/bilder från text. Vi kan alltså ”beställa” en bild i just den stil vi är intresserade av.

Här några exempel från DALL-E.

Och här några från Midjourney:

Det går bra att testa både DALL-E och Midjourney själv. DALL-E hör till OpenAI:s tjänster och hade ännu för en vecka sedan ett kösystem, men nu kan vem som helst skapa ett eget konto till Beta-versionen och testa den. Man får ett visst antal bilder gratis. Det samma gäller Midjourney. På DALL-E-webbsidan som vi länkade till ovan kan man också testa i begränsad utsträckning utan att behöva skapa något konto. För er som använder Discord och är intresserade av att se vad man kan göra med Midjourney kan ni joina deras Discord-server (https://discord.com/invite/midjourney).

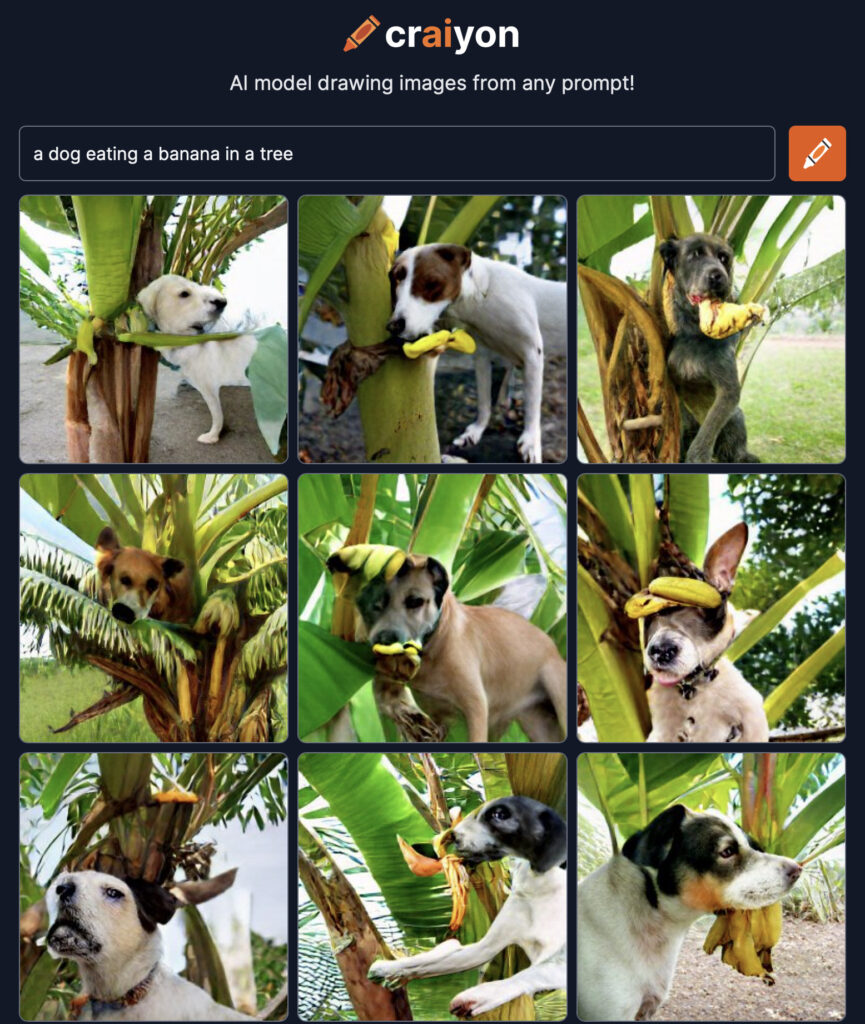

Därtill finns flera ”enklare” versioner som inte alls ger lika bra resultat, men som man kan använda utan konto och som därför t.ex. enkelt också kan användas för att testa och som grund för diskussion i t.ex. undervisningssyfte. En sådan tjänst är craiyon.com.

Riktigt roligt tidsfördriv och dessutom användbart då man behöver en viss typ av bild som man inte kanske har tid eller möjlighet att skaffa just då.

Men som med allt annat kommer även detta med en baksida, inte minst eftersom vi människor tenderar tro på det vi ser. På vilka sätt kan den här typen av teknologi leda till oväntade resultat, eller t.o.m. missbrukas? Fundera gärna lite innan du läser vidare?

I takt med att nya liknande tjänster dyker upp, börjar man också uppmärksamma vad som kan gå fel. Till exempel publicerade Wall Street Journal förra veckan (28.9.2022) en artikel med namn ”AI can now create any image in seconds, bringing wonder and danger”. Det finns t.ex. en oro för att systemen ska skapa bilder som

- bekräftar och bygger på stereotypa fördomar gällande t.ex. etnicitet och genus,

- är plagiat av verkliga konstverk

- kan användas för näthat och mobbning

- material för desinformationskampanjer

- går emot våra värderingar och vår moral

Forskare Kai-Wei Chang vid UCLA I USA konstaterar att det här inte endast är ett tekniskt problem, utan ett samhälleligt sådant. Han menar att det I framtiden kommer finnas bättre system som kan gardera sig mot t.ex. fördomar och bias, men så länge som det finns fördomar i samhället kommer de även att reflekteras i AI-lösningarna. (https://www.nbcnews.com/tech/tech-news/no-quick-fix-openais-dalle-2-illustrated-challenges-bias-ai-rcna39918)